1 Introduction

1.1 Utilité

Quand vous développez une application distribuée, il est très difficile de débugger et de trouver précisément d'où viennent les problèmes dans une architecture. Du fait que le programme utilise plusieurs machines, il est plus complexe de maîtriser parfaitement les échanges d'informations et les accès distants.

C'est pourquoi un besoin de créer un outil permettant de tracer facilement les communications entre objets distants et de présenter le résultat graphiquement s’est rapidement fait ressentir.

1.2 Standards

CorbaTrace est basé sur une nouveauté de la norme Corba 2.3 : les intercepteurs portables. Ils permettent de minimiser la quantité de code source à modifier du côté de l'application hôte pour installer CorbaTrace.

Les résultats de l'interception sont sauvegardés sous forme de fichier XML. Puis, il est possible de leur appliquer des filtres pour choisir ce qu'on souhaite visualiser, pour enfin obtenir un fichier XMI, le format choisi par l'OMG pour sauvegarder les diagrammes UML. Ainsi, il devient possible d'utiliser n'importe quel atelier de génie logiciel pour visualiser le résultat sous forme de diagramme de séquences.

Corbatrace n'est basé sur aucun logiciel propriétaire, mais seulement sur les spécifications de l'OMG. Il est écrit en Java (une version C++ a été commencée), et sa licence d'exploitation est la LGPL (la licence libre de la Free Software Fondation). Aujourd’hui, il est basé sur le nouveau Java SDK 1.4.

2 Présentation

2.1 Historique du projet

Dans le cadre de la maîtrise, ce projet, intitulé "outils d'observation pour une application répartie : société BONOM", a été choisi comme sujet de TER par deux étudiants, Vincent Tricoire et Frédéric Breton. Ce projet consistait, d'une part, à créer des outils d'interceptions de messages circulant entre divers objets d'une application répartie, et d’autre part à concevoir des outils de visualisation spécifiques à la société BONOM.

Les applications réparties utilisent la norme CORBA comme norme de communication. Celle-ci permet de faire communiquer des objets implémentés dans différents langages de programmation.

Pour concevoir un outil d’observation d’applications réparties, il faut être en mesure de surveiller les communications qui circulent entre les différents agents d’une application.

Leur premier objectif dans ce projet était de créer des entités capables d’intercepter les communications entre les agents. Des modules permettant de récupérer les messages envoyés et reçus sont donc intégrer à l’application. Une fois interceptés, ces messages seront stockés de manière à créer des fichiers journaux. Ces fichiers journaux constituent un premier outil d’observation.

Leur deuxième objectif était de réaliser un outil permettant de tracer sous forme de diagrammes les informations contenues dans ces fichiers journaux. L’utilisateur pourra ainsi obtenir une représentation graphique des échanges entre différents agents de l’application répartie.

2.1.1 Les intercepteurs portables

Pour observer les communications entre les différents agents d’une application répartie, plusieurs possibilités s’offraient à eux.

Tout d’abord les deux étudiants pouvaient créer des intercepteurs eux-mêmes, et les fixer sur les objets de l’application qu’ils souhaitaient observer. Ces intercepteurs seront donc dépendants du langage dans lequel les objets observés sont programmés et ne pourront donc être utilisés que pour l’interception de messages basés sur le même langage.

La seconde possibilité consistait à utiliser les intercepteurs spécifiés par la norme CORBA. Les communications interceptées sont indépendantes du langage utilisé pour la création des différents objets de l’application répartie, les intercepteurs étant créés sur le bus CORBA. De plus les messages interceptés sont normalisés suivant la norme CORBA. Mieux appropriée, cette solution sera celle retenue par les deux étudiants.

Les intercepteurs portables doivent être déclarés lors de l’initialisation de l’ORB afin de pouvoir être utilisés. Clients et serveurs définissent des politiques d’interception associées à un niveau d’interception. Ils décident ainsi des communications qui pourront être interceptées.

La politique d’interception permet d’autoriser ou non l’interception.

Le niveau d’interception permet, quant à lui, d’indiquer la quantité d’informations extraites des données interceptées.

On différencie les intercepteurs clients des intercepteurs serveurs. Les intercepteurs clients vont intercepter les messages concernant l’activité d’un client, quant aux intercepteurs serveurs ceux d’un objet serveur.

Tout d’abord des objets Clients, Serveurs et Clients-Serveurs ont été créés afin d’être utilisés lors de communications sur un bus CORBA. Ensuite des actions ont été ajoutées afin de pouvoir intercepter les communications : déclenchement de la construction des intercepteurs et des méthodes répondant à leur invocation, puis établissement d’une politique d’interception associée à un niveau d’interception.

La gestion des interceptions s’est déroulait de la façon suivante :

- mise en place de la structure d’interception

- récupération des données nécessaires à la création de fichiers journaux

- création des fichiers journaux

Une fois l’activation des intercepteurs faite, les données de requêtes CORBA vont être extraites. Ces données étant extraites, elles vont être transformées en chaînes de caractères et écrites dans un fichier journal.

2.1.2 Les fichiers journaux (ou logs)

Un fichier journal est créé par objet. Ainsi, dans le cas où plusieurs objets sont déclarés sur le même serveur ou le même client, l’interception des communications entre ces objets est enregistrée dans des fichiers journaux séparés.

L’intercepteur étant le même pour l’ensemble des objets d’un client ou d’un serveur, il doit alors être capable d’identifier l’émetteur et le récepteur d’un message afin d’écrire dans le fichier correspondant.

Le nombre de fichiers journaux est donc égal au nombre d’objets présents dans l’application répartie. L’idée la création d’un fichier journal par objet permet, en plus du fait d’être facile à lire, d’effectuer une recherche plus simple en ne sélectionnant que les fichiers journaux des émetteurs et récepteurs de requêtes qui nous intéressent.

Pour réaliser ces fichiers journaux, plusieurs informations doivent être récupérées lors de l’observation des communications :

- l’émetteur et le destinataire du message : permet de définir les agents concernés par le message.

- un identifiant de message : cet identifiant permet, ajouté aux deux attributs précédents, d’identifier correctement un message dans deux fichiers journaux et d’en suivre le cheminement d’un bout à l’autre de la communication.

- la date précise d’interception du message : cet attribut ne permet pas d’effectuer la correspondance entre le départ d’un message et son arrivée. Le fait de connaître la date de départ d’un message et celle de son arrivée fournit cependant des informations sur la place du message dans la représentation des communications observées.

- le contenu

du message

Les différents attributs que l’on peut obtenir dans les messages interceptés en fonction des points d’interception appelés ne sont pas toujours les mêmes. Ils dépendent de la nature de l’intercepteur (intercepteur client ou serveur) et de la nature du point d’interception appelé (réponse à une requête, exception, …).

En ce qui concerne l’interception sur les clients, l’identifiant du client n’est donné à aucun endroit. L’idée adoptée consiste alors à demander au client de s’identifier en rajoutant son identifiant comme premier paramètre à toutes ses méthodes déclarées dans les objets du serveur. Celui-ci servira ainsi à identifier un client lors de l’interception d’un message.

De même que pour l’identifiant d’un client, il n’y a pas d’identifiant dans les informations délivrées par les intercepteurs portables de CORBA pour identifier un message. L’idée retenue est donc de demander à l’utilisateur de donner l’identifiant de la requête envoyée comme deuxième argument de ces méthodes.

L’étape suivante consiste à écrire les données interceptées dans le fichier journal de manière à ce qu’elles soient lisibles et à ce qu’il soit facile d’en extraire automatiquement les données pour la réalisation d’un diagramme de séquence.

Voici un exemple d’un fichier journal client :

OPEN_FLUX=Friday,

June 8, 2001 4:57:26 PM GMT+01:00=992015846253

>>>SEND_REQUEST

DATE=Friday,

June 8, 2001 4:57:30 PM GMT+01:00=992015850952

CLIENT_ID=client

SERVANT_ID=Hello

MSG_ID=502196

OPERATION=say_hello_to

ARGUMENTS=3

ARG=in

string(client)

ARG=in

string(502196)

ARG=in string(le

client du POA 1)

OPTIONS

request id = 0

exceptions = (no exceptions)

response expected = true

END_OPTIONS

….

2.1.3 Génération des diagrammes de séquences

Les informations nécessaires à la création d’un diagramme de séquences sont :

- la date

- le nom du client

- le nom du serveur

- l’identifiant du message

- le nom de l’opération (ou s’il s’agit d’une exception)

- les autres données interceptées qui sont plus ou moins importantes selon le niveau d’interception choisi.

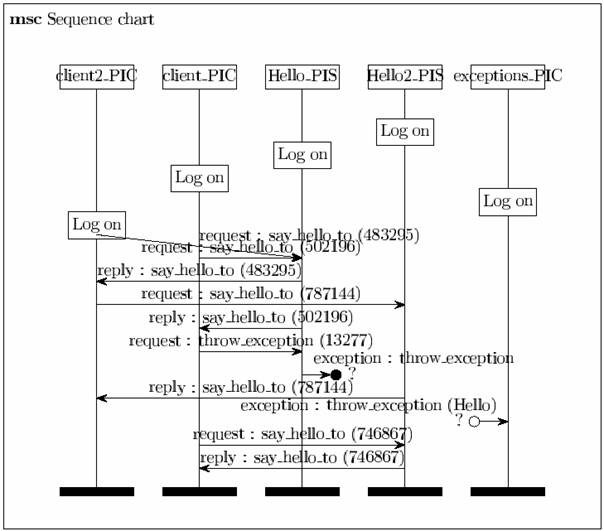

La réalisation des diagrammes de séquence est faite grâce à l’utilisation d’un paquetage Latex. Celui-ci amène des contraintes comme le fait que les communications qui peuvent être représentées ne sont pas basées sur des dates mais sur des décalages et des incréments de niveaux. Cela rend ainsi difficile le juste positionnement des communications les unes par rapport aux autres.

Lors de l’affichage, chaque communication complètes possède un nom comportant le type de la communication, le nom de la méthode appelée et l’identifiant du message. Quant aux communications incomplètes elles sont représentées sous forme d’une flèche interrompue. Elles comportent, pour une exception, le type de la communication, le nom de la méthode qui a levée l’exception et le nom de l’objet serveur mis en jeu.

Voici un exemple de génération d’un diagramme de séquence :

2.1.4 Difficultés rencontrées et travail à faire

Différents problèmes ont été rencontrés lors de l’identification des clients et des messages suite à une interception. La gestion des identifiants de messages et des clients doit être modifiée. En effet ils ne doivent plus être passé en paramètre des différentes méthodes appelées, cette façon de faire étant trop contraignante.

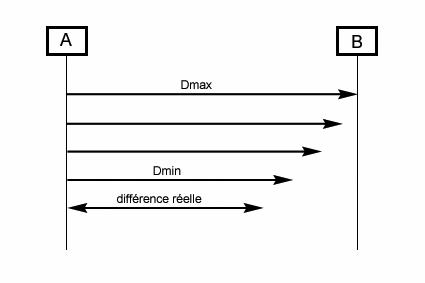

De plus, lors de l’interception d’un message entre un client

et un serveur, ces deux objets peuvent avoir une date différente. Il faut donc

pouvoir synchroniser les différents messages entre eux. En effet, dans le

travail réalisé la date est considérée comme étant la même pour tous, ce qui

n’est évidemment pas le cas dans la réalité.

Se pose également le problème de l’exclusion mutuelle pour l’écriture dans les fichiers des données extraites de l’interception. En effet un point d’interception peut-être levé pendant qu’un autre est en action. Ainsi si les deux points interceptés sont destinés à être écrits dans le même fichier, les deux points d’interception se partagent cette ressource critique. L’écriture concurrente dans le fichier entraîne alors un mélange des deux événements et provoque un brouillage des informations enregistrées.

La représentation graphique ne doit plus être réalisée à l’aide du paquetage Latex uniquement. Les fichiers permettant d’enregistrer les informations relatives à une interception doivent être écrit en XML. Suite à cela des filtres peuvent être appliqués, générant un fichier XMI. A partir de ces fichiers XMI il doit être possibles d’obtenir une représentation graphique sous forme de diagramme de séquence UML avec n’importe quel atelier de génie logiciel.

2.2 Description du cahier des charges

Le sujet de ce projet consistait, suite au travail déjà réalisé dans le cadre du TER, à améliorer l’application en mettant en œuvre une interception moins contraignante et une visualisation graphique plus performante. De plus, le code doit être revu et modifié de façon à être plus propre et plus clair.

Notre application, appelée CorbaTrace, est un ensemble d’outils permettant une représentation des communications entre objets Corba.

L'outil devait être générique et fonctionner avec n'importe quelle application utilisant CORBA.

L’interception des messages sur le bus CORBA est une politique locale, chaque objet distribué peut changer de politique à tout instant s'il le désire. Il est donc possible que les informations contenues dans les différents fichiers journaux soient incomplètes. Ainsi un envoi de message peut être présent dans le fichier journal de l'objet A alors que la réception de cette demande n'est pas présente dans le fichier journal de l'objet B.

Les résultats des interceptions doivent être enregistrés dans les fichiers journaux sous forme de fichiers XML. Des filtres sur les informations que l’on souhaite visualiser pourront être possibles, le résultat de ces filtres étant sauvegardé dans un fichier XMI qui est le format choisi par l’OMG pour sauvegarder les digrammes UML. Il est alors possible d’utiliser n’importe quel atelier de génie logiciel pour visualiser le résultat sous forme de diagrammes de séquence.

2.3 Architecture générale

Pour répondre à ce cahier des charges, nous avons décidé de décomposer en trois modules :

· InterceptoreCore : le cœur de l’interception. Ses classes se placent sur l’ORB et produisent le log

· Log2XMI : le parsage des logs et leur filtrage

· XMIGenerator : la génération des fichiers XMI suivant l’atelier de génie logiciel

Le fonctionnement générale est le suivant (cf. :

· Mise en place de classes utilitaires CorbaTrace dans l’application hôte

· Interception des appels de fonctions distantes par le module Interceptor

· Sauvegarde des informations relatives à l’interception dans un log XML

· Récupération des logs par Log2XMI qui choisie les informations pernitentes grâce à un filtre écrit sous forme de fichier de configuration XML

· Filtrage, fusion et synchronisation des messages

· Envoie des messages à représenter au module XMIGenerator

· Ecriture des fichiers XMI pour générer un diagramme de séquence générique, avec des extensions suivant l’AGL.

Figure 1 : Dynamique générale de CorbaTrace

3 Mécanisme d'interception

Voici l'explication du mécanisme utilisé par CorbaTrace pour mettre en place des logs cohérents. Il est basé sur les standards de l'OMG sur les intercepteurs.

Nous n’allons pas ici ré-expliquer le fonctionnement de Corba car de nombreux ouvrages traitant ce sujet existent.

3.1 Choix technologique

Dans un ancien projet trouvé sur le web dont le but était également de logger les appels Corba, le choix avait été fait d'intercepter les messages au niveau IP. Ce projet n'a jamais abouti car cette méthode a beaucoup d'inconvénient dont la complexité, le filtrage des paquets IP et la dépendance vis à vis de l'ORB.

Le premier ORB à avoir implémenté les intercepteurs est Orbacus. Nous avons donc choisi de l'utiliser, tout en essayant d'en être indépendant et en respectant scrupuleusement les directives de l’OMG. A moyen terme, nous pouvons espérer que notre projet intéresse du monde et dans ce cas, nous aimerions proposer CorbaTrace comme un élément du projet GNU. La première étape sera donc de le tester sur un ORB GNU et pourquoi pas sur la plate-forme Gnome qui repose sur Corba.

Pour le langage, Java a été le premier choisi grâce à sa facilité de codage, sa grande diffusion et sa portabilité.

Un portage vers le C++ a été commencé. Grâce à notre séparation XML entre l’interception et la transformation des logs, seule la partie d’interception a besoin d’être traduite. Et vu que les objets manipulés sont des objets Corba ou des objets standardisés pour tous les langages, le portage ne révèle pas de grandes difficultés. Par manque de temps, nous n’avons malheureusement pas encore fini le codage. Nous espérons le poursuivre dans les semaines qui suivent (il reste à peu près la moitié du travail).

3.2 Principe général

Depuis à peu près deux ans, l'OMG a standardisé une méthode d'interception portable sur les ORBs avec la mise au point de la norme Corba 2.3. Celle-ci permet d'autoriser une interception lors d'une communication entre deux objets Corba, indépendamment de l'ORB. L'interception peut se faire sur plusieurs points, dont l'émission / réception d'un message ou d'une exception.

Ces intercepteurs ont par exemple été utilisés pour gérer les transactions entre objets Corba. Dans ce cas, le client et le serveur n’ont pas besoin d’être modifié pour prendre en compte ce mécanisme. Il suffit de changer la politique de gestion des logs pour que la transaction se mette en route.

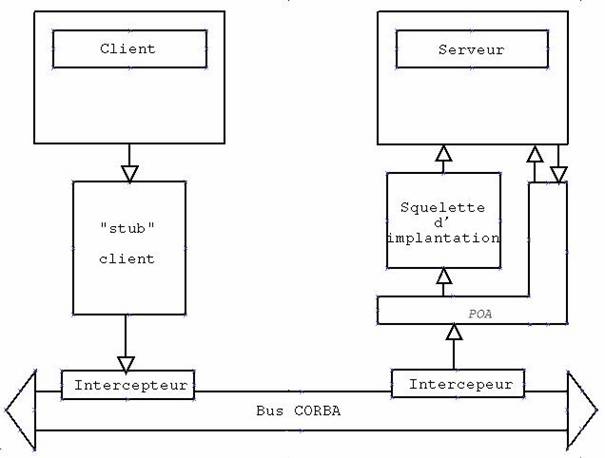

Comme on peut le voir sur la Figure 2, les intercepteurs se placent bien sur le bus Corba. Tout leur mécanisme est caché aux objets métiers.

Par contre, c’est le programme qui met en place ces objets métiers et qui initialise le système qui décide d’activer ou non l’interception. Ainsi, on obtient plusieurs avantages :

· On ne peut pas sniffer une communication Corba sans l’accord de l’application observée

· On peut activer et désactiver dynamiquement l’interception au fur et à mesure des besoins

· On peut régler dynamiquement le niveau d’interception.

Figure 2 : les intercepteurs vus par l'OMG

Pour permettre de régler la quantité d’informations à intercepter, l’OMG a défini un objet Corba nommé LoggingPolicy. Voici son IDL :

#include

"Policy.idl"

//

// The Logger

Policy -- specifies the log level for the

// client and

server Request Interceptor loggers

//

//

// ID for the

Logger Policy

//

const

CORBA::PolicyType LOGGER_POLICY_ID = 1010;

//

// Definition

for the Logger Policy

//

local interface

LoggerPolicy : CORBA::Policy

{

readonly attribute short level;

};

Sachant que LoggerPolicy hérite de Policy, on en déduit donc que l’interception n’est qu’une politique particulière du POA ou de l’ORB, tout comme l’est la persistance, la gestion des cycles de vie ou le contrat transactionnel. Elle permet en outre de stocker une valeur qui représente le niveau d’interception. Ainsi, on décide de la précision et de la quantité des informations à logger. Dans la pratique, un niveau de 1 suffit très largement.

Voici un exemple de mise en place du niveau d’interception pour un POA :

Any any =

orb.create_any();

Policy[]

policies = new Policy[1];

short lglvl = 1

any.insert_short(lglvl);

policies[5] =

orb.create_policy(LOGGER_POLICY_ID.value, any);

POA nouveauPOA = poa.create_POA(“MonPOAIntercepte”, poa.the_POAManager(), policies);

3.3 Mise en place dans l’application à observer

Du point de vue de l'application observée, nous avons limité au maximum la quantité de code à ajouter pour mettre en place CorbaTrace. Pour voir comment procéder exactement, reportez-vous à la documentation utilisateur spécifique. Des classes utilitaires ont été mises à la disposition des applications clientes pour cacher les opérations standardisées à effectuer sur l'ORB pour créer des intercepteurs.

Ces classes sont spécifiques pour un objet Corba client ou serveur. Elles se chargent d'enregistrer les intercepteurs auprès de l'ORB. L'activation est ensuite différente selon le cas client ou serveur, mais la méthode reste semblable.

Pour

activer un intercepteur sur un objet, il faut lui passer un niveau

d'interception. Celui-ci est standardisé par l'OMG et spécifie la quantité

d'information à intercepter. A 0, rien n'est logué. Si aucun niveau n'est

spécifié, on le met par défaut à 1, ce qui suffit amplement pour un débuggage

classique.

Pour

activer un intercepteur sur un objet, il faut lui passer un niveau

d'interception. Celui-ci est standardisé par l'OMG et spécifie la quantité

d'information à intercepter. A 0, rien n'est logué. Si aucun niveau n'est

spécifié, on le met par défaut à 1, ce qui suffit amplement pour un débuggage

classique.

Ensuite, il faut mettre en place l'intercepteur sur le composant. Du côté client, on le met sur l'ORB, alors que du côté serveur, on le met sur le POA. Dans ce dernier cas, un nouveau POA avec les intercepteurs activés est créé dynamiquement à partir d'un POA existant dans l'application cliente (ou du rootPOA). On permet ainsi d'avoir une vision au niveau composants des communications entre objets. Un débuggage "macro-scopique" semble plus utile qu'un débuggage entre objets d'un même composant.

Pour identifier le composant, il est nécessaire de lui fournir un nom sous forme de chaîne de caractères unique dans l'application. C'est ce nom qui apparaîtra dans le diagramme de séquence. Ce nom est sauvegardé dans un slot du PICurrent (voir plus loin).

Une fois toutes ces initialisations effectuées, il suffit d'utiliser les objets métiers. Dans le cas du client, aucune difficulté ne se présente. Mais pour le serveur, il faut juste mettre le servant (l'objet métier serveur) sur le nouveau POA créer dynamiquement par la classe IntercepteurServer.

Il est bien sûr possible de ne logger que le client ou que le serveur ou les deux. Le diagramme de séquence final tiendra compte des manques de certains logs en spécifiant un interlocuteur inconnu.

Pour un mode d’emploi complet, se reporter à l’annexe 9.1.

3.4 Déroulement de l'interception

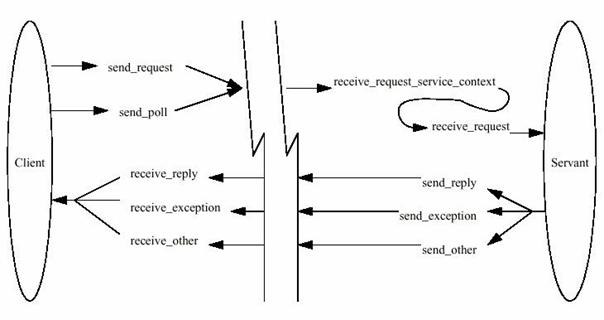

La Figure 4 permet d’avoir une vision globale du mécanisme d’interception.

Figure 4 : les points d'interception

Chaque point d’interception a une fonction particulière qui est exposée brièvement ci-dessous avant d’être expliquée plus précisément.

Du côté client :

· send_request : point qui va être appelé lors de la détection d'un envoi de requête vers un serveur

· send_poll : point appelé lorsqu'un client demande des informations au serveur sur l’état du servant ou sur l’ORB.

· receive_reply : point appelé lors de la réception d'une réponse

· receive_exception : point appelé lors de la réception d'une exception envoyée par le serveur

· receive_other : point appelé lorsqu'on détecte un message envoyé au client qui ne correspond pas à une réponse reçue ou à une exception

Du côté serveur :

· receive_request_service_context : ce point d'interception est appelé avant le point d'interception receive_request pour récupérer, décrypter et transmettre le Service Context dans le request scope.

· receive_request : ce point d'interception est appelé lorsque l'on détecte une réception de requête.

· send_reply : point appelé lors de la détection de l'envoi d'une réponse à une requête

· send_exception : point appelé lors de la détection de l'envoi d'une exception levée par une requête

· send_other : point d'interception appelé quand on détecte l'envoi d'autre chose qu'une réponse ou une exception

3.4.1 Envoi d'une requête

Lorsque le client appelle une méthode sur un objet distant, le mécanisme d'interception Corba précédemment initialisé se met en route.

Tout d'abord, l'envoi de la requête est intercepté côté client par l'intercepteur dont la classe est ClientRequestInterceptorLogger. Le point d'interception est send_request. Si les logs sont activés (le niveau d'interception est supérieur à zéro) alors on va vouloir mettre des informations à destination du serveur. Nous avons besoin par exemple de transmettre l'identifiant du client (car le standard Corba 2.3 des intercepteurs ne permet pas de connaître son identité), la date de l'envoi, le numéro de la requête (il en existe un défini par l'OMG, mais il n'est pas certifié unique à travers IIOP).

Ceci est un problème délicat, et nous avons réfléchi à plusieurs méthodes pour y parvenir. Dans la première version du projet, ces données étaient transmises dans les arguments de chacune des méthodes. Cela impliquait de modifier tous les appels de fonction de toutes les classes de l'application, chose inconcevable en réalité. Nous avons ensuite étudié une solution grâce à une solution à base de communications sécurisées où les deux interlocuteurs se connaissent mutuellement.

Enfin, nous avons opté pour une solution normalisée par l'OMG. Celle-ci se déroule en plusieurs étapes :

· Un slot est alloué à la mise en place des intercepteurs

· L'identifiant du composant est stocké dans un objet Corba (avec une IDL) nommé Dataflow

· Cet objet est sauvegardé dans l'objet normalisé "PICurrent", dans le slot précédemment initialisé

· La requête est effectuée

· Automatiquement, l'ORB transfert le contenu du "PICurrent" dans le contexte de la requête

· Le point send_request est appelé

· L'objet Dataflow est récupéré dans le RequestContext. On lui ajoute la date et l'identifiant unique de la requête

· L'objet Dataflow est sauvegardé dans le ServiceContext, pour être reçu par le serveur.

En utilisant l'objet Dataflow, on n'utilise qu'un seul slot. Ce qui limite encore l'influence par rapport à l'application à observer.

Ensuite, la fonction displayRequestInfo de RequestInterceptorLogger est appelée pour générer le fichier de log en XML, en fonction des informations du contexte d'exécution.

Pour générer ce fichier XML, nous avons choisi de ne pas utiliser DOM car celui-ci demanderait trop de ressources, et ainsi, changerait les caractéristiques du système à observer.

Nous écrivons donc directement dans un fichier et nous utilisons une petite classe qui permet de gérer l'indentation pour le rendre plus lisible.

Pour une explication plus détaillée du contenu des logs, rendez-vous dans le chapitre le fichier de logs en XML.

3.4.2 Réception d'une requête

Après l'émission de la requête du client, celle-ci est transmise par IIOP sur le bus Corba. L'objet serveur (le servant) la reçoit pour répondre à la sollicitation. Mais avant cela, le mécanisme défini par l'OMG défini 2 niveaux d'interception.

Tout d'abord, le premier point d'entrée est receive_request_service_context. Il permet de récupérer le ServiceContext passé par l'objet RequestInfo. L'étape suivante est le décryptage de ce contexte pour récupérer l'objet Dataflow. Pour rendre ses informations disponibles le long des autres étapes de l'interception, on le place dans un slot du RequestInfo.

L'étape suivante se nomme request_intercept. Ce point d'interception est la réception effective de la requête sur le servant. Il suffit donc de sauvegarder dans le log toutes les informations de la requête comme le nom de l'opération, les valeurs des arguments, les informations passées par le Dataflow, etc.

La requête est ensuite transmise logiquement au servant, et l'opération désirée est exécutée.

3.4.3 Le retour du serveur

Une fois la requête exécutée, deux possibilités sont envisageables :

· la requête est asynchrone (oneway) et il n'y a pas de retour.

· la requête est synchrone (cas normal), et on a un retour vers l'objet client, même si la valeur de retour est void.

Pour le retour, nous avons réussi à nous contenter des informations à notre disposition sans avoir besoin de transmettre d'informations du serveur vers le client. Ceci peut bien sûr évoluer en fonction des besoins.

3.4.4 Recéption du retour par le client

Enfin, l'ORB du client intercepte le retour de la réponse par l'élément request_response. Encore une fois, les logs sont sauvegardés dans un fichier XML. C'est à ce moment que s'est posé le problème de l'identifiant unique de requête (cf. chapitre correspondant).

L'objet Client reprend ensuite la main et continue sont travail.

3.4.5 Emission d'exception

La norme des intercepteurs Corba définit deux types d'exceptions.

La première concerne les exceptions utilisateurs. Elles sont émises dans le corps du code source du servant à cause d'une raison propre à l'application elle-même. Elle peut être générée par l'utilisateur, comme par exemple si une chaîne de caractères n'a pas le format voulu par le servant. Ou elle peut être générée par le langage hôte (exemple d'une division par zéro).

L'envoi d'une telle exception remplace alors l'appel au point d'interception send_response par l'appel à send_exception. Bien entendu, certaines informations deviennent ainsi indisponibles telle que l'objet retourné (vu qu'il n'y en a plus).

Le deuxième type d'exception est une exception Corba. Si par exemple, une erreur se produit dans l'intercepteur ou dans le cheminement à travers le réseau, une telle exception est déclenchée. Son fonctionnement est différent de la précédente car les informations concernant cette exception sont stockées dans un argument du RequestInfo nommé sending_exception. On y trouve par exemple la cascade d'exceptions qui ont été déclenchées.

3.5 Utilisation du ServiceContext

3.5.1 Utilité

Pour relier les requêtes stockées dans les logs des clients et des serveurs, il nous faut pouvoir identifier les interlocuteurs. Nous avons donc besoin d’un ID unique pour chaque composant. Chaque requête doit également être identifiée uniquement. L’ORB en fournit toujours un (request_id) qui peut nous être utile mais qui ne peut suffire car elle n’est pas unique à travers IIOP. De plus, il serait très intéressant de transmettre la date de réception d’une requête à son correspondant.

La solution trouvée anciennement avait été de passer toutes ces informations comme arguments des opérations métiers. Il était donc nécessaire de modifier tous les appels de fonctions de l’application hôte. Cette solution n’était donc pas du tout viable.

Une solution envisagée a été d’utiliser le service de sécurisation des appels distants (basé sur ssh). Ce service connaît les deux interlocuteurs car il procède à leur authentification. On impose par contre son utilisation à l’utilisateur.

Notre solution repose en fait sur un mécanisme normalisé par l’OMG depuis peu. Celui-ci permet de faire passer à la fois des informations de l’application hôte aux intercepteurs, de l’intercepteur du client à l’intercepteur du serveur et vice-versa.

Nous en avons déjà parlé dans l’explication des points d’interception, donc nous n’allons pas rentrer dans les détails, mais plutôt nous attarder sur son utilisation générale et son cycle de vie.

3.5.2 Fonctionnement

Le mécanisme général est décrit sur la figure ci-dessous.

Figure 5 :cycle de vie du Service Context

Il existe deux types de contexte : le thread scope et le request scope.

- Le request scope contient des informations qui ne sont disponibles que le temps d’une requête. Seul ce contexte est accessible aux points d’interceptions.

- Le thread scope sert à transmettre des informations entre l’application hôte et les intercepteurs ou du client au serveur (sans passé par un appel de fonction).

Le request scope peut par exemple être utilisé pour transmettre des informations d’un point d’interception à un autre. Sachant qu’il ne faut pas utiliser les variables d’instance de nos classes intercepteurs (car c’est l’ORB lui-même qui gère leur création et la concurrence d’accès aux instances), c’est même la seule manière de faire transiter de l’information.

Avant d’appeler la méthode distante, le client peut accéder au Thread Scope, via un objet Corba nommé PICurrent. Cet objet possède une collection de slots. Chaque slot est identifié par un entier unique et peut contenir un objet de type Any. Cela signifie qu’il est donc possible de transmettre dans un slot toute information que l’on désire.

Le PICurrent possède est caractérisée par une IDL très simpliste

module PortableInterceptor {

typedef unsigned long SlotId;

exception InvalidSlot {};

local interface Current : CORBA::Current {

any get_slot (in SlotId id) raises

(InvalidSlot);

void set_slot (in SlotId id, in any data) raises

(InvalidSlot);

};

};

Pour que le client remplisse un slot du PICurrent, il lui suffit d’exécuter le code suivant :

any myData = ...; // get data from Transaction’s Current

PortableInterceptor::Current pic =

orb.resolve_initial_references (“PICurrent”);

pic.set_slot (mySlotId, myData);

Pour éviter d’utiliser plusieurs slots, nous avons créé une classe Dataflow qui stocke toutes les informations à faire transiter dans le contexte. Cette classe ne sert qu’à stocker de l’information, une simple structure IDL lui suffit donc.

struct Dataflow

{

string client_id;

long long date_send;

long request_id;

};

Quand l’application active les logs sur l’ORB du client, il appelle la fonction activate_log avec en paramètre l’identifiant du composant. Celle-ci crée le Dataflow et l’initialise avec cet identifiant.

public static

void activate_log(ORB orb, String name) {

org.omg.PortableInterceptor.Current pic;

org.omg.CORBA.Object objPic;

try {

objPic = orb.resolve_initial_references("PICurrent");

pic = org.omg.PortableInterceptor.CurrentHelper.narrow(objPic);

Any anyPic = orb.create_any();

Dataflow flow = new Dataflow();

flow.client_id = name;

DataflowHelper.insert(anyPic, flow);

pic.set_slot(RequestInterceptorLogger.slotId, anyPic);

}

catch(org.omg.CORBA.ORBPackage.InvalidName

ex) {

throw new RuntimeException();

}

catch(org.omg.PortableInterceptor.InvalidSlot

ex) {}

catch(org.omg.CORBA.BAD_PARAM ex) {}

}

Une fois les objets initialisés, le client appelle la méthode distante et déclenche le mécanisme d’interception.

Voici pas à pas la suite des transformations effectuées pour la transmission du Dataflow (cf. Figure 5) :

1. Le client appelle une méthode distante sur le stub du servant.

2. Le contenu du PICurrent est automatiquement copié dans le ClientRequestInfo.

3. Le point d’interception send_request(ClientRequestInfo ri) (ou send_poll) est appelé.

Si les logs sont activés, il récupère le Dataflow du slot du ClientRequestInfo par l’appel à getDataflow de la superclasse RequestInterceptorLogger.

protected

Dataflow getDataflow(RequestInfo info)

throws org.omg.CORBA.BAD_OPERATION {

try {

Any any = info.get_slot(mySlotId_);

if( any == null )

throw new

org.omg.CORBA.BAD_OPERATION();

Dataflow flow = DataflowHelper.extract(any);

return flow;

}

catch(org.omg.PortableInterceptor.InvalidSlot e) {

throw new org.omg.CORBA.BAD_OPERATION(e.getMessage());

}

}

Une fois récupéré, il suffit de lui spécifier la date de l’interception ainsi que le request_id courant, et enfin de le transformer en Any.

Any any =

createAny();

Dataflow flow =

getDataflow(ri);

flow.date_send =

new Date().getTime();

flow.request_id

= ri.request_id();

DataflowHelper.insert(any,

flow);

Sachant qu’on utilise IIOP pour transmettre les informations, une étape supplémentaire est nécessaire pour encoder l’objet Any précédemment créé. Enfin, il ne reste plus qu’à créer le Service Context avec ces informations et à l’ajouter à la requête.

// Encode

Dataflow

byte[] data =

cdrCodec_.encode_value(any);

// Add encoded

Dataflow to service context

org.omg.IOP.ServiceContext

sc = new org.omg.IOP.ServiceContext();

sc.context_id =

REQUEST_CONTEXT_ID;

sc.context_data

= data;

ri.add_request_service_context(sc, false);

4. L’intercepteur du serveur est activé par l’appel du point d’interception receive_request_service_contexts(ServerRequestInfo ri). La première action est de procéder aux opérations inverses de celles de l’étape 3. C'est-à-dire : décodage, extraction du Dataflow, ajout de celui-ci dans le request scope du server (par l’intermédiaire du ServerRequestInfo) :

public void receive_request_service_contexts(ServerRequestInfo ri) {

// (les exceptions ne sont pas retransmises par souci de clareté)

System.out.println("receive_request_service_contexts");

if(isLogActivate(ri)) {

Dataflow flow = null;

org.omg.CORBA.Any any = null;

ServiceContext sc= ri.get_request_service_context(REQUEST_CONTEXT_ID);

any = cdrCodec_.decode_value(sc.context_data, DataflowHelper.type());

flow = DataflowHelper.extract(any);

DataflowHelper.insert(any, flow);

ri.set_slot(mySlotId_, any);

}

}

5. La méthode receive_exception est appelée. Il est ainsi possible d’avoir accès à toutes les informations stockées dans le Dataflow qui se trouve dans le ServerRequestInfo. Automatiquement, l’ORB transfert tout le contenu du request scope dans le thread scope du serveur.

6. Le serveur prend la main et réalise la méthode du servant qui a été invoquée. Il peut avoir accès au contenu du Dataflow ou de tout objet passé dans le Service Context par l’intermédiaire de l’objet Corba, PICurrent.

7. à 11. Le processus inverse est déclenché pour le retour de fonction. A chaque fois, les mêmes opérations sont effectuées.

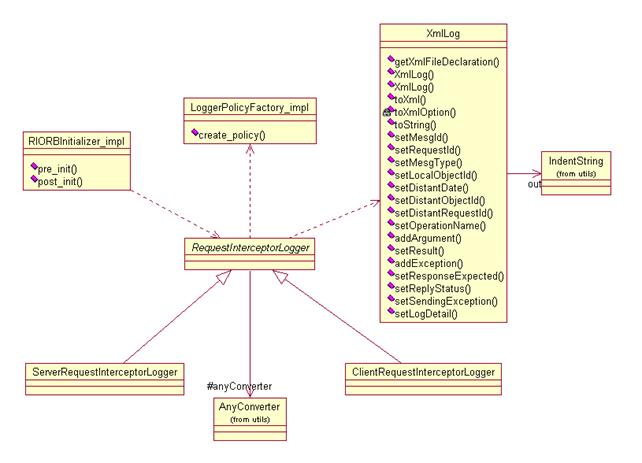

3.6 Architecture des classes d'interception

A la reprise du projet de l'année 2000-2001, l'architecture de CorbaTrace avait été négligée. Le projet s'était concentré sur des problèmes techniques au détriment de la propreté du code. Dès le début, un réaménagement complet des classes a été nécessaire pour clarifier les sources, permettre un débuggage plus rapide et une maintenance bien plus facile.

Le premier travail a été de centraliser la génération du fichier de sortie. Anciennement, chaque classe écrivait son petit bout de log dans le fichier en créant des problèmes de concurrence d'accès au fichier et en rendant très difficile la localisation d'un problème.

La solution envisagée a été de créer le log entièrement en mémoire, et de l'écrire d'un seul coup dans le fichier. On évite ainsi le problème de concurrence d'accès, on gagne en performance et le tout devient plus lisible.

Sachant que le choix du XML comme format de sortie a été retenu, il nous était possible d'utiliser DOM (Document Object Model, de W3C) pour construire le fichier. Mais DOM a un gros problème : il prend beaucoup de place mémoire et il prend du temps machine. Certes, ce n'est pas non plus immense, mais si on veut tracer le comportement d'un programme, il est critique de limiter l'impact de l'interception.

En utilisant DOM, on aurait ainsi de nombreuses millisecondes qui pourraient compromettre l'interprétation des logs. De plus, DOM n'a pas un intérêt pertinent car on a besoin de seulement rajouter des noeuds à l'arbre XML, sans jamais modifier ou supprimer une branche.

Une autre solution (préconisée d'ailleurs par les experts XML pour des applications critiques comme la notre) est de concaténer directement le flux XML dans une chaîne de caractère (une StringBuffer en Java). Nous avons opté pour cette solution, tout en créant une classe utilitaire qui nous permet de gérer l'indentation.

3.6.1 Le flux de sortie

Cette classe se nomme IndentString et se situe dans le package corbatrace.utils. Elle pourrait tout à fait servir dans une autre application que CorbaTrace.

Son unique but est de créer une String tout en fournissant une indentation des balises XML, le tout avec un souci de performance et d'économie de place en mémoire.

Dans notre cas, le fichier XML sert normalement d'entrée au module Log2Xmi, mais il doit également être lisible par un humain car il contient des informations qui se suffisent à elle-même et qui peuvent ne pas être retrouvées dans le diagramme de séquence final.

Pour bien comprendre son fonctionnement, voici un exemple de génération d'un fichier XML.

On veut stocker les caractéristiques d'une personne.

Si on utilisait une simple StringBuffer, on obtiendrait en résultat :

<personne><age>53</age><name

first="Omer" last="Simpsons"/></personne>

En imaginant qu'on doivent stocker ses coordonnées, ses fonctions et qu'on a plusieurs milliers de personnes, le fichier XML est illisible pour un humain.

Le résultat a atteindre est donc :

<personne>

<age>53</age>

<name first="Omer"

last="Simpsons"/>

</personne>

Pour y parvenir, il faut exécuter le code suivant :

IndentString out = new IndentString();

out.insert("<personne>");

out.inc();

out.insert("<age>53<age/>");

out.indent();

out.append("<name");

out.append(" first="Omer"

last="Simpsons"/>");

out.newLine();

out.dec();

out.insert("</personne>");

Voici l'explication des méthodes :

· inc : augmente d'un cran le niveau d'indentation

· dec : diminue d'un cran le niveau d'indentation (remonte dans l'arbre XML)

· append : concatène simplement le texte

· newLine : saute une ligne

· insert : indente, insère le texte et passe à la ligne

Ces fonctions peuvent paraître rudimentaires, mais elles ont l'avantage d'être simples et suffisantes (on peut même les utiliser pour écrire autre chose que du XML).

3.6.2 Récupération des informations

Pour récupérer des informations sur le contexte d'interception, l'OMG a défini un objet nommé RequestInfo passé en argument à chaque point d'interception dont l’IDL est ci-dessous :

local interface RequestInfo {

readonly attribute unsigned long request_id;

readonly attribute string operation;

readonly attribute Dynamic::ParameterList

arguments;

readonly attribute Dynamic::ExceptionList

exceptions;

readonly attribute Dynamic::ContextList

contexts;

readonly attribute Dynamic::RequestContext

operation_context;

readonly attribute any result;

readonly attribute boolean response_expected;

readonly attribute Messaging::SyncScope

sync_scope;

readonly attribute ReplyStatus reply_status;

readonly attribute Object forward_reference;

any get_slot (in SlotId id) raises

(InvalidSlot);

IOP::ServiceContext get_request_service_context

(in IOP::ServiceId id);

IOP::ServiceContext get_reply_service_context

(in IOP::ServiceId id);

};

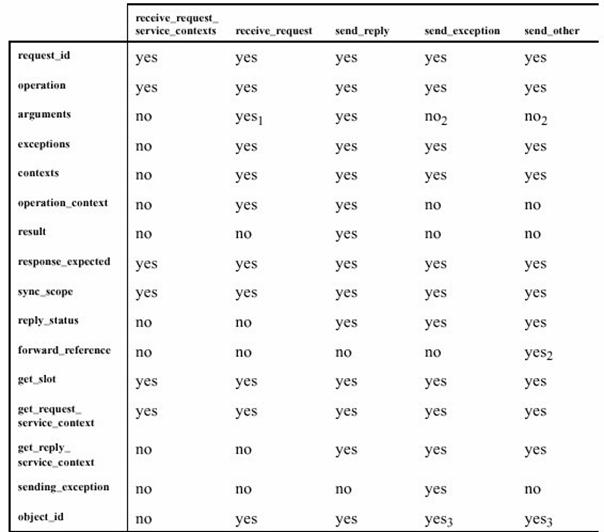

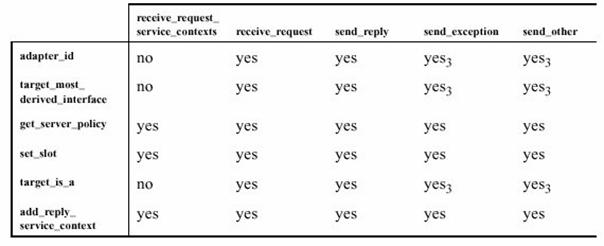

Suivant le type de ce point d'interception et le type de l'intercepteur, différentes informations sont accessibles. Pour être le plus exhaustif et pour ne pas faire nous même le choix des informations pertinentes, nous loggons le maximum d’informations à chaque fois. Le choix des informations à garder se fera au moment du parsage du fichier de log par le module Log2Xmi ou par une application tiers.

Figure 6 : informations disponibles pour l'intercepteur serveur 1/2

Figure 7 : informations disponibles pour l'intercepteur serveur 2/2

Entre l'intercepteur client et l'intercepteur serveur, de nombreuses informations sont communes. Il nous a donc paru tout à fait légitime de faire hériter les deux classes d’interceptions d’une même classe RequestInterceptor.

Celle-ci a comme point d’entrée la méthode displayRequestInfo qui permet de dispatcher la récupération d’information. Toutes les fonctions communes aux serveurs et aux clients sont traitées dans cette superclasse. Dès qu’une information est spécifique au type de l’intercepteur, on utilise une fonction abstraite qui est redéfinie dans les sous-classes. Cette méthode permet une grande souplesse et une factorisation du code maximum.

3.6.3 La construction du log

Dans les premières versions de CorbaTrace, le fichier XML était généré au fur et à mesure de la récupération des informations de l’interception. On utilisait la classe IndentString présentée plus haut pour directement décrire les balises XML et leur contenu. Voici un exemple du mélange entre XML et informations du RequestInfo. On s’attache ici à logger les informations sur l’identité de l’objet local et de l’objet distant et l’identité et la date de la requête.

private void

insertHeader(IndentString out,

RequestInfo info,

String type) {

// get current date and converts it as

String using a defined date format (df).

Date dt = new Date();

String laDate = df.format(dt);

// insert the message type, the date and

time.

out.insert("<message

mesg_id=\"" + nextId() + "\" " +

"request_id=\"" + info.request_id() + "\"

" +

"type=\"" + type + "\">");

// add an indent level.

out.inc();

out.insert("<local_object

id=\"" + getLocalObjectId(info) +

"\" date=\"" + laDate + "\"/>");

insertDistantObject(out, info);

out.newLine();

}

Dès qu’une modification de la DTD avait lieu, il fallait retrouver dans les 3 classes d’intercepteurs où se situait la ligne concernée, ce qui n’était pas aisé. De plus, si on voulait utiliser plusieurs formats de log, il fallait refaire tout le code.

Bien sûr, ces problèmes étaient loin d’être critiques, mais leur résolution permet d’optimiser l’architecture globale de l’interception.

Une solution envisagée a donc été de séparer la récupération spécifique à Corba des informations à logger, de la génération du XML.

Ainsi, la classe XmlLog a été mise au point pour centraliser la génération du XML. Elle possède des méthodes du type setXX qui servent à stocker les informations récupérées de l’interception. Elles ne prennent en paramètre que deux types de variables : une String ou une collection de String. Ainsi, la classe XmlLog n’a pas à s’occuper de conversion qui de toute façon ne la concerne pas.

Une fois tous les méthodes d’affectation des données appelées, il suffit d’exécuter la méthode toString() qui va renvoyer le fichier XML. Toute la génération est ainsi centralisée dans une seule fonction, ce qui permet une modification du log de sortie très facile. Il peut également être très facile de créer une autre classe de log qui utilise les mêmes méthodes mais qui produit un log différent.

3.7 Contenu du log

3.7.1 Pourquoi XML ?

En reprenant le projet, les logs étaient stockés sous forme de fichiers en texte brut, avec un semblant de syntaxe propriétaire. Le parsage de ces logs était très fastidieux.

Le choix de XML a donc été immédiat grâce à sa facilité de parsage (avec SAX), de génération et de manipulation (avec DOM), grâce à son universalité et grâce à sa bonne intégration avec Java.

De plus, le format de présentation des communications Corba choisi est le XMI. Ce format utilise XML comme format de sauvegarde. Notre choix nous permet ainsi une architecture cohérente et homogène.

XML a encore d’autres avantages qui sont loin d’être négligeables :

· Possibilité de relecture humaine des logs

· Indépendance des plate formes et des langages

· Séparation entre les différents modules (et donc meilleure organisation du travail en équipe)

3.7.2 Explication des balises

Chacune des balises va être décrite précisément dans le chapitre suivant, où l’on décrit le parsage des logs.

3.7.3 La balise de fin

Un problème récurrent à tous les systèmes d’écriture de flux constants XML est la balise de fin XML. En effet, on écrit régulièrement dans le fichier de log en concaténant à chaque fois les nouvelles informations à sauvegarder (la balise <message> et ses sous-balises) avec les informations déjà écrites.

Pour la balise de début et la déclaration XML, le problème ne se pose pas car on peut l’écrire à la création du fichier. Pour la balise de fin, nous avions pensé pour contourner le problème à rajouter la balise de fin par un tout petit script shell ou par l’application récupérant les logs sur les différents ordinateurs.

Mais cette méthode aurait été une transgression du principe de cloisonnement entre émetteur et récepteur de flux XML. Nous avons donc opté pour une solution plus compliquée mais qui à l’avantage de produire en sortie de l’interception un fichier XML bien formé.

La solution consiste à écrire à la suite des nouveaux logs, la balise de fermeture </log>. A la prochaine ouverture du fichier pour un nouveau log, on effacera cette balise avant d’écrire les nouvelles informations.

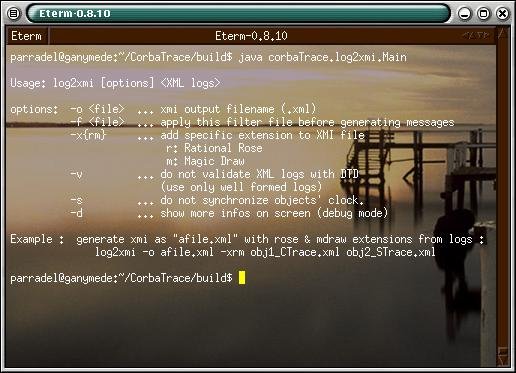

4 Log2XMI

4.1 Introduction

Cette partie s’intercale comme le montre le schéma entre la partie de l’application « interception des messages » et la partie « visualisation des diagrammes de séquence ».

Sa finalité est de transformer les différents fichiers

d’interception des messages (les fichiers de logs) qui sont au format XML (avec

une DTD qui nous est propre), en un

fichier unique au format XMI, une DTD standardisée par l’OMG, appropriée pour

les représentations en diagrammes de séquences.

.

.

.

Pour cela, nous avons décomposé le travail en 5 étapes distinctes :

- L’analyse des différents fichiers de logs (parsage). Ces fichiers ne contiennent des informations que sur des demi-messages, ou plus précisément sur l’envoi d’un message ou sur la réception d’un message.

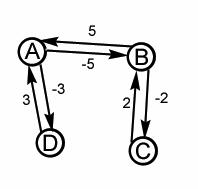

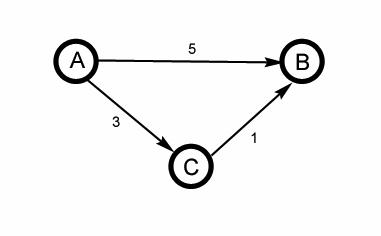

- La fusion des demi-messages. On regroupe les demi-messages correspondants afin d’obtenir un message complet.

- La synchronisation de tous les messages complets et incomplets obtenus, afin d’obtenir une séquence chronologiquement correcte des messages.

- Le filtrage des informations. Toutes les données interceptées ne sont pas forcément intéressantes, on choisit ce que l’on considère comme le plus pertinent.

- Création du fichier XMI, à partir des informations précédentes.

Nous allons maintenant présenter l’architecture globale de ce module, les choix effectués et leurs justifications, puis ensuite présenter les différents types de messages que nous avons besoin, puis présenter en détail les différentes étapes du processus.

4.2 L’architecture globale

Lorsque s’est posée la question de réaliser l’application, nous avions l’objectif de pouvoir rajouter des fichiers de logs « à chaud ». C’est-à-dire que, après avoir lancer le traitement une première fois sur des fichiers de logs, on voulait s’offrir la possibilité de compléter les logs existants et obtenir le bon résultat sans pour autant relancer tout le traitement. Cela a impliqué de pouvoir sauvegarder, au moins en mémoire, les résultats obtenus et de pouvoir ajouter facilement les compléments d’informations.

Ensuite, puisque nous sauvegardions déjà des résultats en mémoire, nous nous sommes dit que ces résultats pouvaient aussi servir à modifier « à chaud » les options des filtres, en relançant le traitement uniquement à partir de ces sauvegardes. En effet, relancer tout le travail en amont serait futile si seules quelques options de filtres ont changé. C’est d’autant plus judicieux que CorbaTrace est sensé être un outil de débuggage, et que lorsqu’on débugue, on avance généralement par tâtonnement pour situer l’erreur.

De même, pour la création du fichier final, il existe plusieurs outils de visualisation qui possèdent leur format de fichier XMI propre. Même si XMI est normalisé, une partie (les extensions) est laissée sans contraintes pour permettre à chaque outil UML d’y apporter ses informations propriétaires. Les sauvegardes de données permettent la génération des fichiers XMI sous des formats différents, sans forcément ré-effectuer l’intégralité du processus.

L’analyse préliminaire a donc aboutie à une architecture qui réalise les étapes l’une après l’autre (pas de parallélisme de tâches), et qui sauvegarde des données après chaque étape.

Bien évidemment, toutes modifications des données d’une étape relance le traitement sur toutes les étapes en aval.

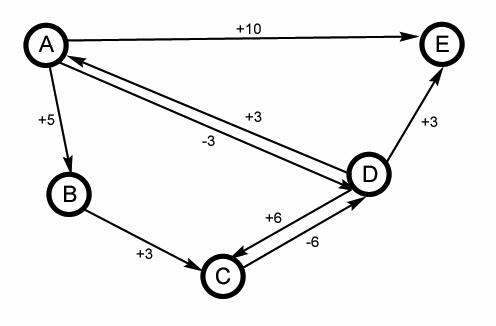

Le diagramme UML ci-dessus décrit notre architecture globale. On remarque

que chaque étape est réalisée par un objet indépendamment des autres étapes.

Donc chacun de ces objets a la possibilité de sauvegarder ce dont il a besoin.

4.3 Solution pour une reprise à chaud

Notre système doit permettre de rajouter des logs qui n’avaient pas été

pris en compte lors d’un premier parsage. A terme, il pourrait mettre être

possible de visualiser en temps réel les interactions entre objets distribués.

Nous avons essayé de procéder à des choix architecturaux nous permettant

d’ajouter des logs sans avoir à tout reconstruire à chaque fois. Avec la futur

interface graphique, l’intérêt de ce mode de fonctionnement deviendra vite

évident.

Pour détailler plus précisément ce qui peut être sauvegardé, repris, ou

modifié, nous allons reprendre le séquencement des étapes une à une. Chacune de

ces étapes sera décrite plus précisément dans les chapitres qui suivent.

1. La première étape qui concerne le parsage, n’a aucune raison de ré-analyser les fichiers déjà analyser. Nous considérons que lorsqu’un fichier est traité, il l’est une fois pour toute. Les demi-messages qui en sont extraits sont stockés (non pas au niveau de cette étape, mais à l’étape suivante) et ce fichier n’a plus d’utilité. Cela oblige par contre l’utilisateur à ne pas ajouter des logs qui existent déjà, même s’ils ont des informations complémentaires (seules les informations complémentaires nous intéressent). Pour résumé, l’étape de parsage ne prend en compte que les nouvelles séries de fichiers qui ne doivent comporter que des informations nouvelles.

2. La seconde étape, celle qui fusionne les demi-messages pour obtenir des messages complets, mémorise tout les messages complets déjà obtenus. Une fois un message complet obtenu, il n’a aucune raison d’être modifié. Nous identifions nos deux moitiés de messages de telle manière qu’aucune information ne peut remettre en cause ce qui a déjà été fait. La sauvegarde des données nous a semblé ici très évidente à réaliser. Nous sauvegardons aussi à cette étape les demi-messages, obtenu lors d’un parsage, et auxquels nous n’avons put associer leur moitié. Ces demi-messages pourront plus tard être associés avec des nouveaux demi-messages lorsque de nouvelles informations arriveront. Pour résumé, dans cette étape, pour chaque parsage effectué, nous réalisons une opération de fusion uniquement sur les demi-messages (ceux obtenus au cours du parsage, et ceux obtenus au cours d’un traitement antérieur).

3. La troisième étape traite de la synchronisation des messages. Pour cette étape tout est remis en question. Il est très incertain de synchroniser de nouveaux messages à partir d’une synchronisation déjà existante, cela tout simplement parce que nous pouvons obtenir un message dont la réception intervient avant l’envoi. Ce qui est totalement aberrant. Pour chaque nouveau message, ou lot de nouveaux messages obtenus, nous sommes donc obligé de relancer la synchronisation.

4. La quatrième étape est le filtrage des données. Ces filtrages d’informations sont des sélections des données pertinentes à partir des données obtenues. Par conséquent si les sélections changent, mais que les données ne changent pas, il n’y a pas de raison de relancer l’intégralité du traitement. Nous mémorisons donc ici l’intégralité des messages synchronisés, complets et incomplets, obtenus précédemment,

5. La cinquième étape est la génération, à partir des données filtrées obtenues, d’un fichier XMI pour un outils bien précis. Ici aussi, quelque soit l’outil de visualisation, si les données filtrées ne changent pas, il n’y a pas de raison de relancer l’application. Les différents fichiers XMI peuvent être obtenus à partir des mêmes données en modifiant seulement une option du générateur de fichier.

4.4 La structure des messages

Pour les besoins de notre application nous avons besoin de pouvoir différencier différentes sortes de messages. C’est pour cela que nous avons réalisé l’architecture décrite ci-dessous.

Comme on peut le voir sur ce diagramme UML, nous avons une classe abstraite Message qui se dérive en classes HalfMessageSource, HalfMessageDestination et EntireMessage. Ces différentes classes répondent à nos besoins pour modéliser les différentes sortes de messages auxquelles nous sommes confrontés, c’est–à-dire les messages complets (EntireMessage) et les demi-messages qu’ils soient interceptés à la source (HalfMessageSource) ou à leur destination (HalfMessageDestination). Un message est donc constitué d’un type qui nous indique si le message est une exception, une requête ou une réponse, et s’il est complet. S’il n’est pas complet, c’est donc un demi-message source ou destination. Le cas échéant, ce type peut aussi indiqué que le message est incomplet, mais cette information n’est utile que pour la visualisation du diagramme de séquences.

Comme nous n’avons pas qu’un seul message à manipuler, il nous faut disposer de collection de message. Ces collections existent sous la forme des classes ObjectMessage et MessageCollection. La collection ObjectMessage répertorie tout les messages liés à un seul objet, ces messages sont ensuite classés chronologiquement. La classe MessageCollection n’est ensuite qu’une collection de ces ObjectMessage, qui sont classés par ordre alphabétique des identifiants de message. Ce choix de structure nous permet de classer très précisément les messages dont on dispose, et par la suite de parcourir nos collections très facilement, et sans perte de temps.

Les MessageFilter quant à eux nous permettent de modéliser les messages avec des données filtrées. Ce sont donc des messages avec des informations volontairement épurées.

4.5 Le parsage des logs

4.5.1 Le choix de XML

Comme dit précédemment, nous avons fait le choix de définir des fichiers de logs en XML.

Ce choix se justifie par plusieurs points :

- XML est à l'heure actuelle un format qui s'impose comme le format de manipulation de données le plus utilisé, notamment par sa facilité de lecture.

- Il existe deux standards pour la manipulation des fichiers XML : DOM et SAX. Grâce à cet effort de standardisation, des moteurs de parsage pour XML existent dans la plupart des langages pour SAX et DOM (c'est le cas en Java notamment, avec JAXP, directement intégré depuis le JDK 1.4, mais aussi par des bibliothèques tierces comme Xerces). De fait, le parsage de fichiers XML en est facilité.

- XML par sa simplicité est très adapté à des transformations. Des langages comme XSLT permettent de transformer des fichiers XML en d'autres fichiers XML. C'est le format universel par excellence, souvent utilisé comme format commun pour faire communiquer les données de plusieurs applications entre elles.

- XML définit deux types de documents : les documents bien formés, c'est à dire cohérent vis à vis des syntaxes utilisées par XML (tags d'ouverture, de fermeture, etc.), et les documents valides, plus intéressants car basés sur une DTD. La DTD définit en un sens les règles de production de la grammaire utilisée pour les données XML. Définir une DTD est donc un gage de qualité dans le traitement des fichiers XML.

4.5.2 Les logs et leur DTD

Nous avons donc défini une DTD pour les logs. Nous définissons aussi dans cette DTD les bons formats de filtres (nous y reviendrons plus loin).

Pour définir cette DTD, notre souci est de pouvoir loguer le maximum d'informations interceptées, même si une bonne partie d'entre elles ne nous est pas directement utile pour définir les diagrammes de séquence.

Le principe est d'encapsuler tous les messages sous un tag <log> </log>.

Cela permet de les distinguer d'un filtre <filter> </filter>.

C'est donc le point d'entrée du fichier XML.

Chaque log est donc formé de messages :

<!ELEMENT log (message*)>

Chaque message est formé d'informations sur l'objet local, sur l'objet distant s'il y en a, sur l'opération du message, son résultat, puis l'ensemble de ses options loguées.

Chaque message possède aussi un identifiant de message, ainsi qu'un identifiant de requête, et un type de message (send_request, receive_request, send_reply, receive_reply, etc.)

Chaque objet, local ou distant, possède comme informations l'identifiant de l'objet, et la date à laquelle l'objet a émis ou reçu le message (en horaire local à l'objet).

Pour la DTD, nous avons fait le choix de plutôt favoriser l'utilisation d'attributs que de sous-éléments XML. C'est généralement un débat entre utilisateurs d'XML. Il nous a semblé intéressant d'utiliser des sous tags lorsqu'il y avait réellement une notion d'encapsulation. Par exemple les arguments d'une opération ou les messages d'un log. Lorsque les informations décrivent davantage un statut ou une valeur unique d'un objet, nous préférons utiliser des attributs pour le tag (c'est le cas par exemple des identifiants de messages ou d'objets).

Tout cela reste évidemment bien subjectif.

Ici, nous avons donc les messages de la DTD sous la forme :

<!ELEMENT

message (local_object, distant_object?, operation, result?, options?)>

<!ATTLIST

message

mesg_id CDATA #REQUIRED

request_id CDATA #REQUIRED

type CDATA #REQUIRED>

<!ELEMENT

local_object EMPTY>

<!ATTLIST

local_object

id CDATA #REQUIRED

date CDATA #REQUIRED>

<!ELEMENT

distant_object EMPTY>

<!ATTLIST

distant_object

id CDATA #REQUIRED

date CDATA #REQUIRED

request_id CDATA #REQUIRED>

Chaque message est aussi composé d'une opération. Celle-ci est formée d'arguments.

Chaque argument a un type de donnée associé, une valeur, une information pour indiquer la sorte de paramètre (entrée, sortie, ou entrée/sortie), et enfin, accessoirement, un nom d'opération.

Le résultat de l'opération est quant à lui défini par un type de donnée et une valeur de résultat. Le résultat est bien sûr optionnel au niveau du message puisque seuls des messages de réponses (reply) peuvent donner une telle information.

L'opération est ainsi décrite comme suit dans la DTD :

<!ELEMENT

operation (argument*)>

<!ATTLIST

operation

name CDATA #REQUIRED>

<!ELEMENT

argument EMPTY>

<!ATTLIST

argument

inout (in|out|inout) #REQUIRED

name CDATA #IMPLIED

value CDATA #REQUIRED

type CDATA #REQUIRED>

<!ELEMENT

result EMPTY>

<!ATTLIST

result

type CDATA #IMPLIED

value CDATA #IMPLIED>

Les options arrivent ensuite. Celles-ci parfois optionnelles. Nous nous sommes basés pour cela sur les spécifications Corba qui décrivent quelles informations les intercepteurs Corba peuvent récupérer, et donc quelles informations sont loguables.

Les options sont les suivantes :

<!ELEMENT

options (

request_id?,

exceptions?,

contexts?,

operation_context?,

responseExpected?,

sync_scope?,

reply_status?,

forward_reference?,

slots?,

request_service_contexts?,

reply_service_contexts?,

sending_exception?,

object_id?,

adapter_id?,

target_most_derived_interface?,

server_policies?,

target_is_a?,

target?,

effective_target?,

effective_profile?,

received_exception?,

received_exception_id?,

effective_components?,

request_policies?,

)>

Sans rentrer trop dans le détail, on peut distinguer deux catégories d'options :

- les options qui n'ont qu'une ou plusieurs informations simples. Ce sont des tags avec généralement un attribut ou plusieurs attributs de type chaînes (#CDATA).

Ainsi, un request_id, received_exception_id, adapter_id, et object_id ont tous un attribut "id", responseExpected et target_is_a une seule valeur (value), “sync_scope” une valeur parmi “sync_none”, “sync_with_transport”, “sync_with_server”, et “sync_with_target” (l'information est obligatoire, d'où le #REQUIRED dans la DTD pour cet attribut de l'option), reply_status a cinq possibilités ( successful , etc.).

L'option “effective_profile” a une information de tag et une de profile (profile_data).

D'autres valeurs d'attributs courantes sont le type (forward_reference, sending_exception, received_exception, target, effective_target), l'IOR (forward_reference, target, effective_target), ou encore un nom ou une simple valeur.

La DTD est ainsi définie comme suit pour ce type d'options :

<!ELEMENT

request_id EMPTY>

<!ATTLIST

request_id

id CDATA #REQUIRED>

<!ELEMENT

responseExpected EMPTY>

<!ATTLIST

responseExpected

value CDATA #REQUIRED>

<!ELEMENT

sync_scope EMPTY>

<!ATTLIST

sync_scope

value (sync_none |

sync_with_transport | sync_with_server | sync_with_target) #REQUIRED>

<!ELEMENT

reply_status EMPTY>

<!ATTLIST

reply_status

value (successful | system_exception

| user_exception | location_forward | transport_retry) #REQUIRED>

<!ELEMENT

forward_reference EMPTY>

<!ATTLIST

forward_reference

type CDATA #REQUIRED

implementation_name CDATA #REQUIRED

IOR CDATA #REQUIRED>

<!ELEMENT

sending_exception EMPTY>

<!ATTLIST

sending_exception

name CDATA #REQUIRED

value CDATA #REQUIRED

type CDATA #REQUIRED>

<!ELEMENT

object_id EMPTY>

<!ATTLIST

object_id

id CDATA #REQUIRED>

<!ELEMENT

adapter_id EMPTY>

<!ATTLIST

adapter_id

id CDATA #REQUIRED>

<!ELEMENT

target_most_derived_interface EMPTY>

<!ATTLIST

target_most_derived_interface

id CDATA #REQUIRED>

<!ELEMENT

target_is_a EMPTY>

<!ATTLIST

target_is_a

value CDATA #REQUIRED>

<!ELEMENT

target EMPTY>

<!ATTLIST

target

type CDATA #REQUIRED

implementation_name CDATA #REQUIRED

IOR CDATA #REQUIRED>

<!ELEMENT

effective_target EMPTY>

<!ATTLIST

effective_target

type CDATA #REQUIRED

implementation_name CDATA #REQUIRED

IOR CDATA #REQUIRED>

<!ELEMENT

effective_profile EMPTY>

<!ATTLIST

effective_profile

tag CDATA #REQUIRED

profile_data CDATA #REQUIRED>

<!ELEMENT

received_exception EMPTY>

<!ATTLIST

received_exception

name CDATA #REQUIRED

value CDATA #REQUIRED

type CDATA #REQUIRED>

<!ELEMENT

received_exception_id EMPTY>

<!ATTLIST

received_exception_id

id CDATA #REQUIRED>

- la seconde catégorie d'options est celle des options qui encapsulent une ou plusieurs information(s). L'opération est dans ce cas même si elle est traitée à part. Cette distinction est aussi faite dans notre structure de message, un MessageOption pouvant encapsuler un autre MessageOption et ainsi de suite.

Nous avons par exemple les exceptions qui sont formées d'une ou plusieurs exception(s), les contextes qui sont formés de plusieurs contextes qui eux-mêmes ont une ou plusieurs propriétés (property), chaque propriété ayant un nom ou une valeur. Un contexte d'opération (operation_context) est lui aussi formé de plusieurs propriétés du contexte (context_property) :

<!ELEMENT exceptions (exception)*>

<!ELEMENT

exception EMPTY>

<!ATTLIST

exception

name CDATA #REQUIRED>

<!ELEMENT contexts (context)*>

<!ELEMENT

context (property)*>

<!ELEMENT

property EMPTY>

<!ATTLIST

property

name CDATA #REQUIRED

string_value CDATA #REQUIRED>

<!ELEMENT

operation_context (context_property)*>

<!ELEMENT

context_property EMPTY>

<!ATTLIST

context_property

name CDATA #REQUIRED

string_value CDATA #REQUIRED>

De même l'option des slots est composée de plusieurs slots, chacun ayant un id (slot_id), un nom (name), une valeur (value), et un type.

Les options request_service_contexts et reply_service_contexts sont toutes deux composées de service_context, chacun de ces contextes ayant un id, un identifiant de service (service_id), et des données (data). De même les politiques de serveur (server_policies) et de requête (request_policies) sont formées de policy (avec la politique en tant que telle et son type), et enfin les composants effectifs formés de plusieurs composants (avec le tag et les données du composant) :

<!ELEMENT slots

(slot)*>

<!ELEMENT

slot EMPTY>

<!ATTLIST

slot

slot_id CDATA #REQUIRED

name CDATA #REQUIRED

value CDATA #REQUIRED

type CDATA #REQUIRED>

<!ELEMENT request_service_contexts (service_context)*>

<!ELEMENT

reply_service_contexts (service_context)*>

<!ELEMENT

service_context EMPTY>

<!ATTLIST

service_context

service_id CDATA #REQUIRED

id CDATA #REQUIRED

data CDATA #REQUIRED>

<!ELEMENT

server_policies (Policy)*>

<!ELEMENT

request_policies (policy)*>

<!ELEMENT

policy EMPTY>

<!ATTLIST

policy

policy_type CDATA #REQUIRED

policy CDATA #REQUIRED>

<!ELEMENT

effective_components (effective_component)*>

<!ELEMENT

effective_component EMPTY>

<!ATTLIST

effective_component

tag CDATA #REQUIRED

component_data CDATA #REQUIRED>

Bien sûr, la meilleure façon de cerner le format des logs est de visualiser un exemple de log en soit. Référez-vous à la partie sur les interceptions proprement dite pour avoir un exemple sûrement plus utile à la compréhension.

Ainsi, l'intérêt d'utiliser XML et de définir une DTD pour nos logs est particulièrement bénéfique pour plusieurs points :

- les logs sont faciles à lire, même si très volumineux.

- les logs sont plus aisés à parser grâce aux librairies compatibles avec SAX et DOM définies pour la plupart des langages.

- et surtout, le format étant particulièrement maniable, il peut tout à fait intéresser d'autres développeurs qui souhaitent définir leur propre outil de traitement des logs, quitte à passer par un format de fichiers plus personnel, après avoir effectué une phase de transformation des logs (avec XSLT par exemple).

4.5.3 Le parsage des logs par l'outil log2xmi

4.5.3.1 Le choix de SAX

Pour le parsage des logs, nous utilisons les librairies prédéfinies en Java, et intégrées au JDK depuis sa version 1.4.

Pour le parsage du fichier XML, nous avons le choix entre SAX et DOM :

- avec DOM, le fichier est entièrement parsé sous forme d’un arbre. L’ensemble du fichier XML se trouve donc en mémoire. Chaque nœud voisin détermine les attributs et chaque nœud fils les sous éléments (les tags imbriqués). L’avantage est que le parsage se fait de manière automatique, donc il n’y a ensuite plus qu’à parcourir l’arbre et effectuer les opérations souhaitées. DOM est très adapté à des DTD très détaillées, et prend tout son intérêt dès qu’il s’agit de générer à partir de l’arbre un autre format de fichier (xml ou non).

- avec SAX, nous retrouvons une utilisation plus classique des outils de parsage comme Yacc ou Cup par exemple : à chaque réduction de règle détectée, il faut définir l’action à réaliser, généralement l’ajout d’un élément dans une structure interne. Pour XML, la notion de règles est simplifiée à son maximum : il s’agit en fait de détecter les tags de débuts et de fin, ainsi que le début et la fin d’un document XML donné. Sax est plus adapté à la construction incrémentale des données en mémoire, au fur et à mesure de la lecture du fichier XML, et sous la forme d’une structure interne plus utile à l’application que ne le sont les arbres de DOM.

C’est pour cette raison que nous avons fait le choix d’utiliser plutôt SAX, puisque notre structure de messages est, selon nous, mieux adaptée aux futurs traitements à appliquer sur l’ensemble des messages (fusion, synchronisation, et filtres).

DOM, par contre est particulièrement utile dès que les structures XML des fichiers à parser deviennent trop lourdes, ce qui n’est pas vraiment le cas de nos logs. DOM est par exemple bien plus adapté à la construction des arbres XMI. Nous y reviendrons beaucoup plus en détail par la suite.

4.5.3.2 SAX et Java

Nos avons utilisé SAX dans sa version 2. Des packages pour SAX2 sont définis depuis très peu de temps dans le JDK (depuis la version 1.4). Le moteur de parsage de la machine virtuelle est connu sous le nom de JAXP. Pour les versions antérieures, on peut lui substituer le parseur Xerces disponible en GPL. D’autres parseurs compatibles avec SAX2 peuvent aussi être utilisés (et peuvent se révéler plus performants). A partir du JDK1.4, il est possible de définir les librairies à utiliser par défaut soit globalement dans la configuration du jdk, soit en passant en paramètre au compilateur le package à substituer à celui par défaut du JDK1.4.

Comme nous avons aussi fait le choix d’intégrer les filtres à la DTD, donc aussi sous forme de fichier XML, nous trouvions intéressant de définir une classe de parsage commune aux deux processus de parsage (les logs et les filtres). Cette classe « GenSaxParser » (du package corbaTrace.log2xmi.parser) permet de bien comprendre l’initialisation du parser SAX2.

Pour fonctionner, le parseur nécessite un handler (qui dérive de DefaultHandler). C’est dans cet handler que l’on définit ce que doit faire le parseur lorsqu’il a détecté un nouveau tag d’élément XML. On définit donc par la suite un handler pour les logs (LogHandler) et un autre pour les filtres (FilterHandler) que l’on passe initialement au constructeur et que GenSaxParser utilisera à chaque nouveau fichier XML.

Le principe est le suivant :

1) création d’une nouvelle « fabrique » de parsage (SAXParserFactory)

SAXParserFactory factory = SAXParserFactory.newInstance();

2) définition ou non de l’état de validation du parser. En effet, si on le souhaite, par défaut c’est le cas, mais l’utilisateur peut indiquer une option à la commande log2xmi pour ne pas valider les fichiers XML. Ceci est surtout utile pour les filtres puisqu’ils sont modifiés à la main par l’utilisateur, donc sont susceptibles de contenir quelques erreurs par rapport à la DTD.

factory.setValidating(validatedXML);

3) un nouveau parseur est alors créé : (saxParser est une donnée membre de la classe, de type javax.xml.parsers.SAXParser)

saxParser = factory.newSAXParser();

4) Ensuite, dès qu’un nouveau fichier XML est donné à parser, on le passe en paramètre à une méthode startParsingFile() (sous forme de fichier ou d’URL). Celle-ci appelle la méthode parse() du parseur créé précédemment pour ce fichier et pour l’handler correspondant (celui des filtres ou des logs) :

saxParser.parse(file, handler);

Ensuite, à chaque fin ou début d’élément XML (<element>, </element>), un événement est provoqué par le parseur, cet événement est traduit en un appel de méthode du Handler utilisé.

Chaque Handler doit donc redéfinir les méthodes suivantes :

- startDocument() : elle est appelée au début du fichier XML.

-

endDocument() : elle est appelée en fin de document XML.

-

startElement() : elle est appelée dès qu’un nouveau tag

ouvrant est détecté.

On détermine alors le tag en question, et en fonction des actions qu’on

souhaite effectuer pour ce tag, on lit chaque attribut du tag à partir du

paramètre d’attributs de la méthode (objet de la classe Attributes). A partir

des méthodes getLocalName(numero_attribut)

et getValue(numero_attribut), on peut

déterminer le nom et la valeur de chaque attribut pour cet élément XML (et

exploiter cette valeur).

- endElement() : elle est appelée dès qu’un nouveau tag fermant est détecté.

- characters() : elle est appelée lorsqu’une chaîne se trouve entre deux tags ouvrant et fermant.

Ainsi que les méthodes d’erreur de parsage : error() (appelé à chaque erreur si la validation du fichier à partir de la DTD est activée), et fatalError() (problème de document mal formé).

Dans notre cas, chaque erreur de parsage provoque une exception qui est propagée à la méthode appelante (startParsingFile()), qui la propage elle-même à la classe qui demande le parsage, à savoir LogstoXmi, qui se charge alors d’afficher la ligne et le message d’erreur.

Comme chaque information terminale (les chaînes de caractères qui forment l’information, #CDATA dans la DTD) est sous la forme d’attributs d’élément XML, aucune information terminale ne se trouve entre deux tags ouvrant et fermant. La méthode characters() n’est donc pas utilisée.

4.5.3.3 Le parsage des logs

Nous définissons un parseur spécifique pour les logs. Il hérite du parseur générique GenSaxParser. Il utilise un handler pour les fichiers de log (LogHandler) et propose deux méthodes d’accès à des Collections de messages (getHalfDestinationMessages() et getHalfSourceMessages()) pour récupérer les messages incomplets lus à partir des différents fichiers parsés.

Le parseur appelle en fait ces mêmes méthodes depuis son handler de logs.

LogHandler définit la manière d’exploiter les données parsées depuis les fichiers de logs. Il conserve deux collections de messages correspondant à l’état actuel des messages lus sans erreur, et correspondent aux messages dont seule la destination est connue (de type receive_request, receive_reply, ou receive_exception), c’est à dire à des HalfMessageDestination, et ce dont seule la source est connue (de type send_request, send_reply, ou send_exception), c’est à dire à des HalfMessageSource.

Le principe général de fonctionnement de LogHandler est le suivant :

- on travaille avec un objet Message temporaire.

- dès qu’il y a une incohérence ou une erreur de parsage, le message temporaire est détruit (car non exploitable).

-

à chaque élément lu (méthode startElement() appelée), on détermine

quel est le tag en question. Si c’est un <message>, alors on initialise

le Message temporaire, soit comme HalfMessageSource, soit comme

HalfMessageDestination, en fonction du type de message lu pour l’attribut

« type » de l’élément. Ensuite, pour chaque option, on crée un

MessageOption temporaire dans le lequel on ajoute les informations nécessaires.

Si besoin est, dans le cas d’options encapsulées, on utilise une liste d’options

temporaires. C’est lorsque le tag de fin est détecté (endElement()) que la

liste des options est définitivement ajoutée pour le MessageOption temporaire,

ou que le MessageOption temporaire est définitivement ajouté dans le Message

temporaire, ou s’il s’agit d’un message qui se termine, celui-ci est

définitivement ajouté dans la liste des messages incomplets (source ou

destination, selon le type du message), et le message temporaire est libéré.